前回,心理学評論特集「心理学の再現可能性:我々はどこから来たのか 我々は何者か 我々はどこへ行くのか」についてレビューしたが,この再現性問題についてはそのほかにも様々な動きがある.

そのような試みの一環として,科研費・挑戦的萌芽研究「社会心理学の再現可能性検証のための日本拠点構築(代表:三浦麻子・関西学院大学教授)」と慶應義塾大学・三田哲学会の共催により,こうした動きの最前線で活躍されているDaniel Lakens博士(Eindhoven University of Technology)を招いて,9月22日に慶応大学三田キャンパスで講演会とワークショップが開かれた.

当日は土砂降りのあいにくの天気だったが,参加してきたので,内容を紹介したい

(参考サイト)

https://sites.google.com/site/kgasasemi/replicability/jsps_kakenhi/activity_log/20160922lakensws

Improve Your Statical Inferences Daniel Lakens

今日はより良いリサーチをするために統計的なお話をしたい.データから行う推論をより改善するにはどうしたらいいのか,それを用いて何をしたいのか,どうすればより効率的にできるのかがテーマになる.

<導入>

かつて理論物理学者のリチャード・ファインマンは「科学者が最も気をつけなければならないことは自分を騙さないということだ.自分を騙すのはいとも簡単だから」と語った.

理論と統計的仮説の間は実証問題(corroboration problem)であり,統計的仮説とデータの間は統計的推論問題になる.

ここでプリコグニション論文の話がある.被験者に次の画面で左右どちらにpositiveな絵が出るかどうかを先に予想してもらい,次にコンピュータでランダムに絵を出す.被験者の予測が当たる傾向が有意であるという論文があるのだ.(心理学評論では「超能力論文」とされていたもの.Lakensさん自身はこのような論文が出たことを聞いて最初冗談かと思ったそうだ)

すべてのリサーチで主張される発見のどのぐらいが誤りなのだろうか.有意水準が95%だから5%と考えていいのか.そうではないのだ.

もちろんこれはエリアによる.DNAのような巨大なデータが得られる分野ではそれはかなり低いだろう.しかし心理学実験ではそれほど大きな標本数にはなかなかならない.

追試して再現できるかという問題も簡単ではない.同じ結果とは何かという定義の問題もある.

<基本的な問題>

一旦データから統計的推論をしたとして,私たちの前には3つの問題がある.

- これから何をすべきか

- 何を信じるべきか

- 相対的なエビデンスとは何か

まず第1の問題から

<何をすべきか>

これは頻度主義の話.ここではフィッシャー流ではなくネイマン=ピアソン流の頻度主義を主に取り上げる.こちらの方が現在の心理学リサーチでは多いからだ.

これは長期的にあまり間違いを犯さないためにはどう行動すべきかという問題へのアプローチへの答えになっている.基本的な枠組みはp>αならH0を否定,p>αならH0を受け入れるか懐疑のままにするという行動則になる.そしてこれは1回のテストのことをいっているのではなく,繰り返し実験を行う上での長期的な行動をいっているのだ.独立のリピートが極めて重要だ.(ヒッグズ粒子の発見においては独立の2チームが同じ実験を同じ設備で行ってつきあわせている)

- 「コインを10回はじいて6回表が出たとする.このコインは偏っているだろうか.」

これを尤度から考えるのが尤度主義やベイズ主義になる.尤度主義では2つの仮説の相対的尤度比を考え,ベイズ主義ではデータに事前予想を組み入れて仮説が正しいことについての事後確率を求める.

頻度主義ではこれをp値を使ってアプローチする.(ここでフィッシャーとネイマンの違いを解説.フィッシャーの方が少し尤度的だとコメントがある)

ここで最も重要なのは,これらの3つの主義が,どれかが正しくてどれかが誤りというような排他的な関係にあるわけではないということだ.目的に合わせてどれでも使えるし,並列的に使っても問題はない.データを使って何をしたいのかが問題になるのだ.

<p値について>

では頻度主義の要であるp値とは何か.

多くの批判がありながらなぜp値はこれほどつかわれているのだろうか.

p値とは「偶然に騙されないための最後の防衛ライン」なのだ.シグナルをノイズと分離するための仕掛けなのだ.

p値は「もし何の効果もないとしたならば,そのデータはどのぐらい驚くべきものか」を表している.データを分析して低いp値を得たときには「おお」と驚くべきなのだ,勝利の雄叫びを上げてはいけない.

何の効果もないとしたときのデータの分布を予想し(それが正規分布として),得られたデータがその両側の裾野の部分に入れば驚くべきということになる.

心理学実験ではαは0.05(両側で1.96シグマ)と置くことが慣習になっている.しかし物理学では5シグマを要求するエリアもある.

よくある誤解はp値が0.04であれば,この仮説が正しい確率は96%だと考えてしまうことだ.これは誤りだ.p値は対立仮説が正しい確率を与えない.帰無仮説にについてもそうだ.それを知るにはベイズ推定が必要になる.

p値はこのデータがどのぐらい驚くべきかを示しているだけであり,これからどうすべきかを示すのが頻度主義になる.そして頻度主義のガイドに従えば,長期間であなたが間違う確率は5%未満に抑えられるのだ.

p値がαより大きいときにはリサーチはdegenerativeな過程に入らざるを得なくなる.角度を変えてやってみる.では別の仮説へというような具合になる.p値が様々だとメタ分析が必要になる.p値は思慮深さと理解のために用いるのだ.最終的な結論を得るための道具なのだ.

(pがαより大きいときには基本的にはそれはNo conclusionだ.対立仮説の効果がないということではない.この誤解も多い)

このp値の性質から,その分布を考えることができる.対立仮説が正しいときのp値の分布,帰無仮説が正しいときのp値の分布はそれぞれどのようになるだろうか.

対立仮説が正しいときの分布はそのパワーに依存する.パワーが強ければ強いほどp値が低いほど密度の高い左に偏った分布になる.そして帰無仮説が正しいときには一様分布になる.これは直感的にわかりにくいかもしれないが,本来p値はそうなるようにデザインされているものだと考えれば納得できる.

このあたりは多くの人が誤解しているところだ.しっかり頭にたたき込んでおこう.

<エラーコントロール>

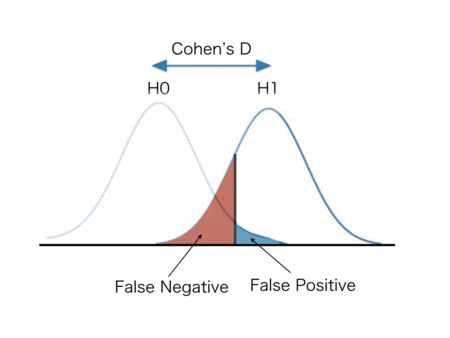

ネイマン=ピアソン流の頻度主義のポイントはエラーコントロールにある.

タイプ1のエラーを避けるためにαを設定し,タイプ2のエラーを避けるためにβを設定する.

これらはトレードオフで長期間でコントロールする.

そしてエラーマネジマントを最も効率的に行う上で重要なのは,効果量と対立仮説の正しさについての事前確率だ.(αやβは大きくは効かない)効果量は現象の性質に依存するので動かせない.だからリサーチャーにとって重要なのは対立仮説をいかに「仮説が正しい確率」の高いものを構築できるかということになる.これは結局理論に精通し,関連エリアを理解していい仮説を立てるかということになる.

αやβの設定は,結局どのようなエラーを重視するかということで基本的にはモラルの問題になる.多くの心理学研究では慣習的にαを0.05に設定する.あたかもモーゼの十戒のようだ.ただしそうしなければならないわけでないことを理解しておくことは重要だ.βについてはコーエンが80%を推奨している(ただしこの推奨が無視されることを望むともいっているのだが)私自身はしばしば95%を使っている.

<事前登録>

事前登録制はタイプ1のエラーを減らすことができる.

それはデータについてマルチ分析をして都合のよいものだけを報告するというp-hackingを防げるからだ,一番最初に話したプリコグニションはなぜああいう報告が可能になったのか.それはリサーチャーは報告対象になった画像種類(この場合エロチックな画像のpositive, negative)だけでなくその他の様々な画像種類でも実験を行っているからだ.

事前登録によって,あるリサーチが探索的なリサーチではなく確証的なリサーチであることが明確にできる.探索的なリサーチ自体に価値がないわけではないが,それはそのまま検証には使えない.covariateなテストにはエビデンスの価値はないのだ.

実は医学分野では査読誌による事前登録制が既に実施されている.そもそも結果が人命にかかわるという極めて高い倫理性が要求される分野であり,かつ医薬品ビジネスでは莫大な金が動くためにこのあたりについては(心理学より)はるかにシビアだ.(なお医学分野では再現可能性への担保は,もちろん事前登録制だけではなく,そもそも連続した厳しいプロトコルが要求され,最後には厳格に統制された実験が必要とされていることにも多くをよっている)

実際に2000年頃から事前登録制をとっている査読誌では,リサーチのうち有意差があるものの報告比が17/30から2/25になっている.

- HARKing

さらに探索的リサーチと確証的リサーチの問題としてHARKingもある.HARKingとはデータを得てからそれを見て仮説を組み上げることだ.当然ながらそのデータで仮説を検証することはできない.やれば循環論法になってしまう.

- その他のp-hacking

サンプルサイズの正当化:データを集めながら何度も分析し,pがαを下回ったらデータ収集をやめるというものだ.

独立変数と従属変数を事前に決めておかない:様々な分析をしてから事後に決める

これらの問題についても事前登録制は効果がある.分析プランを事前にきちんと記述させておけば,事後の操作はできない.探索的調査は予備調査として独立に行い,仮説を立て,実験プランを作って事前登録する.そこから真の検証実験を行うという手続きになる.

- 事前登録サイトの紹介

現在ではフリーで使えるリサーチャー向けの事前登録サイトがいくつかある.私自身も使っているし,学生にも推奨している.

Open Science Framework https://osf.io

Aspredicted https://aspredicted.org

(ここで実際の登録のデモ)

<Q&A>

Q:

ここで登録した後で削除はできるのか,もしそうなら意味がないのでは

A:

確かにサイトによっては削除が可能になっている.本当に厳しく運用するなら査読誌による事前登録制を敷くしかない.査読誌による事前登録なら出版バイアスも減らせる.

ただし査読誌による事前登録制にもコストがある.ライバルに知られたくないという問題はおいておくとして,一旦リサーチプランを事前登録すると,その後いいアイデアがあって計画を向上させたいと思ってもエディターの了解を取り付ける必要が出てくる.そのリサーチャーが真に誠実ならただ面倒くさいだけだ.結局心理学で現在事前登録制の査読誌がないのはそのあたりの事情もある.

Q:

データを見て仮説を得たい場合にはどうすればいいのか

A:

探索的なリサーチ自体には問題はない.やったことをそのまま誠実に報告すればいい.それには価値がある.ただしそれ自体で検証にはなり得ないということ.あるいはデータをベイズ的に取り扱うという方法もある.

QRPsといわれているものも,何をやったかをすべて書けば基本的に問題はない.一部を報告しないところから問題が生じる.

ここで午前の部が終了.お昼は土砂降りの中,三田の商店街へ.さすがに学生街だけあった焼き肉屋さんが多い.そういうわけで韓国風和牛焼肉丼を

午後からはさらに微妙なところについて

<頻度主義における有意差,効果量,標本数,変数の性質などの問題>

帰無仮説は効果がゼロということだが,ほとんどどんな効果も完全にゼロということはない.であれば標本数を大きくしていくと非常に小さな効果でも有意差が生まれる.

またランダムなアサインメントがあるかないかによっても分析は変わってくる.例をあげれば様々なアンカー効果の報告は(最初のアンカリングに使う値を連続的に変化させてランダムにアサインメントできるので)効果量が大きい報告がなされているが,様々な行動性差(男性か女性かの2値しか無い)の報告は有意差があっても効果量の小さいものが多い.

6000人調べて小さな性差が観測されたからといってエキサイティングとは言えない.現実世界では性によって様々な状況が異なる.それはシステマティックなノイズの影響である可能性が高いと考えるべきだ.

要するにランダムなアサインメントがないと対立仮説はボールドな予測にならないのだ.

<強い予測の価値>

では性差のようなリサーチはどうすればいいのか.

一つの方法は強い予測をすることだ.そしてそれがどのような実験で否定できるか(反証実験)を考える.

性差があるかないかの予測ではなく,性差が(最低でも)どのぐらいあるかを予測するのだ.そしてそれが検証されればそれには価値がある.

ヒトにはコンファーメーションバイアスがあるので,反証実験を考えつくのには心理的抵抗がある.(ここではWason's 2-4-6 problemをスライドに映しながら解説.)しかしそこには価値がある.帰無仮説が成り立つかどうかよりも,二つのピンポイントの予測のどちらがよりありそうかを調べ,片方が排除できるならそれは強い検証になる.

常に「あなたの仮説を否定するにはどのような実験結果があればいいか」を考えるのだ.それにより追試もずっと楽になる.もちろんこれは難しいことが多い.でも可能ならそれを用いる方がいい.

<Equivalent Test>

対立仮説が最低効果量をピンポイント予測していれば,Equivalent Testができる.最低効果量があるとしたときの確率分布を立てて,片側検定する.

予測最低効果量が大きいときには,帰無仮説が有意に否定されても,なお最低効果量はありそうもないという領域が存在する.

<標本数と最低効果量の関係>

実験計画を立てるときに標本数はどう決めるか

パワー分析によることが多いだろう.そうするとαとβと効果量から決まってくることになる.この効果量をどう決めるかというのは少しトリッキーだ.そもそもこの効果量が知りたいから実験するという側面もあるからだ.一つのやり方は関連リサーチをよく調べて推定するというものだ.

そしてもう一つ考え方がある.それは「自分は最低どのぐらいの効果量がある現象を調べたいのか」を自分ではっきりさせることだ.それ以下ならそもそも興味深い現象ではないと考えておけばいい.効果が大きな現象に興味があるなら標本数はそれほどいらないことになるのだ.

効果量0.8以上のことが知りたいなら(α0.05,β0.8で)比較2グループで20人ずつでいい.心理学実験おける平均的な効果量は0.43といわれているが,それなら86人ずつということになる.

逆に言うとあるサンプルサイズを決めるということは,自分が気にしている最少効果量を宣言しているのと同じことになる.

<逐次分析>

そうはいってもデータを集めながら途中で分析したいことはある.しかし恣意的なストップルールはp-hackingそのものであり,重大な問題がある.

ここでそういう場合に用いることのできる手続きがある.最初に何回分析するかを決めておいて,それぞれの際にZ値でテストするという逐次分析手法があるのだ.Z値を一定値にする手法や可変にする手法などいろいろある.大まかには,2回分析で5%有意を考えるときに,αに対応するZと比較すべき数字は0.05ではなく0.0294になる.

これは医療実験の世界ではよく使われている.それは実験にはヒトを用いているのでいろいろな倫理的な問題があるからだ.途中で効果がはっきりわかるなら,実験はやめて対照群の患者にも治療を行うべきだし.効果がはっきりないなら実験自体中止して別の治療を試みるべきだということになる.

なおベイズではいつでもデータを止められる.ベイズ主義者は事後確率に関心があるのであって,エラーマネジメントには関心がないからだ.

逆に医療の世界ではエラーに非常に敏感にならざるを得ない.だからベイズには行きにくい.しかし心理学では考慮の価値があるだろう.

<片側検定>

片側検定はp-hackingを疑われやすい.その方が甘くなるからだ.しかし物事の性質からいって,絶対に逆方向の効果がないと信じられるなら,片側検定は許容されるべきだ.例えば社会的排除実験で,「排除されて気分がポジティブになるということがありうるだろうか,いやない」と考えれば片側検定でいいことになる.その場合には標本数を節約できることになる.

ただし実務的には必ず統計学者に相談することをお勧めする.またこれについても事前登録は信用を得るために重要なツールになる.

<pカーブ分析>

午前中に帰無仮説,対立仮説のp値の分散の話をした.帰無仮説が正しい場合にはp値は一様分布になり,対立仮説が正しい場合には左肩上がりの分布になる.

つまり,対立仮説が正しい場合と帰無仮説が正しい場合で分布が異なるのだ.するとメタ分析で実際に報告されるp値がどのように分布しているかで,そのどのぐらいの割合がタイプ1エラーになっているのかを推測できることになる.

関連サイト pcurve.com

ここではテーマごとのメタ分析例を取り上げよう.

心理学では様々なプライミングが報告されている.実際のテーマごとにp値の分布を見ると

老齢プライミングメタ分析では分布は右肩上がり(0.01以下のp値は報告数が少なく,pが0.04,005になるにつれて報告例が多くなる)になっている.これはどのような混合状態でも生じない.だから何らかのp-hackingが行われたことが推測できる.

教授プライミングメタ分析では0.04のところに小さな怪しい山はあるが,全体的に美しい左肩上がりの分布になっている.基本的に発見はロバストだが,一部p-hackingがあるのかもしれないと推測できる.

標本数が少ない場合でも,0.01, 0.08, 0.04, 0.04, 0.04などのp値が現れるのであれば相当疑わしいと考えていいだろう.実際にこの5サンプルについて一様分布と左肩上がり分布のどちらに近いかを統計検定すると,p=0.0054で左肩上がりではないということになる.

<尤度主義>

尤度主義はすべてが相対的な世界だ.問われる問題は(冒頭の3つの問題のうち3番目の)「相対的なエビデンスはどうなっているか」になる.

あるデータが得られたとき,ある仮説のもっともらしさ(likelihood:尤度)を,仮説のパラメータを変数とした関数で表すことができる.

例としてはコイン投げをする場合の2項分布の尤度関数 L(θ) は以下のようになる.(このコインの持つ表が出る確率を仮説のパラメータθ,試行数 n,表が出た回数 xとする)

L(θ)=n!/x!(n-x)!・(θ^x)・(1-θ)^(n-x)

10回投げて8回表が出たというデータがあるとする.

すると,尤度Lを縦軸に,θを横軸にグラフがかける.これはデータが8/10の時の尤度カーブということになる.

そして尤度主義で重要なのは二つの仮説の尤度比だ.

8/10のときにH1( θ=0.5)とH2(θ=0.8)の尤度比は6.87という計算ができる.

この尤度比が相対的なエビデンスになる.p値は帰無仮説のありえなさを示しているだけであって対立仮説の確からしさに関係がないのに対して尤度比は対立仮説の確からしさについて直接のエビデンスになっているのだ.

しかし万能ではない.そもそもあまりありそうではない仮説同士の比較はどんな高い尤度比が出てもあまり意味はない.

と例えばコイン投げのデータが50/100 のときに,H1( θ=0.3)とH2(θ=0.8)の尤度比は尤度カーブの裾野地点同士の比較で80000以上になる.このデータのものではどちらの仮説も真である確率は非常に低い.だからこの尤度比にはあまり意味はないのだ.

<尤度主義からみた頻度主義の仮説検定>

この尤度主義を使って頻度主義の世界を分析することも可能だ.

H0(θ=0.05):α=0.05のときの帰無仮説

H1(θ=0.8):β=0.8のときの対立仮説

データ:複数のスタディの中でいくつ有意さが報告されたか

データが2/3(3つのスタディがありそのうち2つで有意さが報告されている)のときのH0とH1の尤度はそれぞれ0.0024,0.128になり,尤度比は54となる.つまり3報のうち2報で有意であれば,対立仮説は帰無仮説より54倍尤度が高いのだ.

ここから重要な事がわかる.多重研究は混合的な結果になりがちだということだ.βが0.8であれば,対立仮説が正しいとしても3/3になる確率は0.51しかないのだから.尤度カーブを並べていけば多くの場合に混合的になることが視覚的にも明らかだ.論文を投稿する際に混合した結果であっても自信を持ってエディターや査読者と対峙すればいい.

<ベイズ主義>

ベイズは事前確率をフレームワークに取り込む.これは信念をデータによってアップデートしていく過程として考えていい.つまり(冒頭の3つの問題のうち2番目の)「何を信じるか」についてのアプローチになる.

- 「コイン投げで3回とも表が出たとする.このコインはフェアだろうか.」

もしあなたが生まれたばかりで世界のことを何も知らなければ「次も表が出るだろう.コインはおそらくフェアではない」と考えるだろう.しかしあなたがコインの性質をよく知っていて,極端にアンフェアなコインはごく希にしかないことを知っているなら,3回の試行ではこのコインがフェアでないという結論にはまだ早い.

この公式により事前確率にデータをコンバインし.事後確率が計算できる.

事前確率も仮説のパラメータに対していろいろな形がありうる.先ほどの例でいうと全く予想がないときにはよく一様事前分布が(uniform prior)使われる.ほとんどのコインはフェアだと思っているならθが0.5のところにに鋭いピークを持つ形になるし.表が出やすいと思うなら右肩上がりの事前確率分布になる.

<ベイズの二つの使用法>

ベイズの利用は主に二つある.

- ベイズファクター(BF)

一つはベイズファクターを使うもの.これはあるパラメータ値に対する事後確率が事前確率に対して何倍になるかを表すもの.コイン投げでいうと当初一様分布であり,10/20のデータが得られれば,θ=0.5の事後確率が上昇する.このときのベイズファクターは3.7になる.

ベイズファクターの評価については,一般的に3でマイルドな効果,10で強い効果があると評価されることが多い.

(ここでベイズファクターカリキュレーターの紹介)

- ベイズ推定

もう一つはベイズ推定だ.これは事後確率を計算するもの.θが一定範囲に入る場合の事後確率を示したり,事後確率が95%になるθの範囲を信頼区間として示したりするものだ.

<ベイズファクターとp値>

はじめの方に述べたように,頻度主義とベイズ主義は,そもそも念頭にある問題が異なるので,併用しても全く問題がない.

そうすると多くの場合BFとp値は同じような状況を示す.しかし時に異なる結果を示すことがある.これを理解しておくのは重要だ.

仮想的な例でいうと,仮に99%パワーのある対立仮説を考えているとする.この場合もし対立仮説が正しいなら十分にデータを集めるとp値はほとんど0.001より小さいということになる.ここでp値が0.04というのはほとんど起こりえない.この場合には帰無仮説が正しい方が(尤度比で)ずっとありそうだということになる.しかしベイズファクターを用いればこの問題は生じない.p値が0.04になるようなデータであればベイズファクターは大きな値を示さないのだ.

また事前確率分布が要因になることもある.

いずれにしても両方で分析し,相反したときにはよく調べた方がいい.

<Open Science>

オープンサイエンスとは,リサーチをオープンにしようという志向を指す.論文,データ,マテリアル,査読プロセス,教育,リソースすべてにアクセスを認めようということだ.

論文についてはいま3つの流れがある.

- ゴールドオープンアクセス:オーサーが査読誌にカネを払い,後はすべてオープンというもの.

- グリーンオープンアクセス:読者(大学など)が査読誌に購読料を払うが,オーサーはワークプリントを公開できる権利を持つ(自分のWeb pageなどで公開できる)というもの.こうなっているとGoogle scholarで検索した後で簡単にPDFが得られる.そして引用される確率は上がる.論文がこのクラスにあるかを調べるサイトもある(SHERPA/ROMIO)

- SCI-HUB:ある信念に基づく人々が運用している完全な違法コピーサイト.ここでは利用等について推奨しないが,将来の姿を垣間見せてくれているようだというコメントはしておく.

データ

データを共有できる方が科学はより生産的になる.私はデータを公開するようにしている.直接の利益はないが,名声は上がる可能性があるし,実際にリジェクトされにくくなったように感じている.ただし,第三者に再分析されて自らの誤りが暴露されるリスクがあることは承知しておかなければならない.これも分析について再チェックを入念に主なうようになり,いい影響があるとも言える.

オランダではRaw Dataを10年保存しておかなければならないという大学の規則がある.

データを保存しておくなら,コードにコメントをつけておくことを推奨する.自分でも何が何だかわからなくなるからだ.生データ.分析データ,図表をきちんとパッケージしてわかりやすくまとめておく.

以上が講演の内容だ.統計の認識論,哲学を分かり易く解説し,さらに実務的なアドバイスにあふれ,非常に充実した内容だった.強い予測の価値の話は大変啓発的だった.統計の3つの主義については以前,統計哲学の本を読んでいたのが大変役にたったという印象だ.

統計の科学哲学についてはまずこの本.私の書評はhttp://d.hatena.ne.jp/shorebird/20130811

- 作者: エリオット・ソーバー,松王政浩

- 出版社/メーカー: 名古屋大学出版会

- 発売日: 2012/10/20

- メディア: 単行本

- 購入: 5人 クリック: 105回

- この商品を含むブログ (20件) を見る

ベイズ統計の考え方にかかる概要はこの本でかなりわかる.私の書評はhttp://d.hatena.ne.jp/shorebird/20131228

- 作者: シャロン・バーチュマグレイン,Sharon Bertsch McGrayne,冨永星

- 出版社/メーカー: 草思社

- 発売日: 2013/10/23

- メディア: 単行本

- この商品を含むブログ (28件) を見る